アゼストでは、ChatGPTを活用して、テクニカルな内容の共有やテクニックの研究などをまとめた社内テックブログを運用しています。

そのブログの中から厳選した内容をいくつか公開いたします!

今回は、データエンジニアチームの山下が作成した、大規模言語モデル(LLM)の認識しやすい言語の特徴と、英語をLLMがさらに認識しやすい言語に改良するための方向性について解説した記事をご紹介いたします!

LLMについての知識

You:

あなたは大規模言語モデル(LLM)についての詳細な知識を持っていますか?

ChatGPT:

はい、大規模言語モデル(LLM)についての詳細な知識を持っています。

具体的な質問や情報が必要であれば、お知らせいただけますか?

You:

LLMの構造について説明してください。

ChatGPT:

大規模言語モデル(LLM)の構造について簡潔に説明します。

- レイヤー: 多数のエンコーダーレイヤーが積み重なっています。

- トランスフォーマーアーキテクチャ: LLMはトランスフォーマーのアーキテクチャを基にしていることが一般的です。

- 自己注意機構: 各単語が他の全ての単語との関係を計算する機構。

- フィードフォワードネットワーク: 非線形性を加える層。

- ポジショナルエンコーディング: 単語の順序情報を提供。

- 正規化と活性化関数: 各レイヤーの出力を安定化。

他に何か詳細な情報が必要であれば、お知らせください。

You:

例えばChatGPTに質問するときのように、LLMに質問を投げかけると、LLM内部ではどのように処理が行われますか?

具体的に詳しく教えてください。

ChatGPT:

LLMに質問を投げかける際の内部処理について、具体的に説明します。

- 前処理: 入力テキストのトークン化、ポジショナルエンコーディングの付加。

- エンコーダー層の処理:

- 自己注意機構: 入力間の関係性計算。

- フィードフォワードネットワーク: 非線形変換。

- 層ごとの正規化。

- デコーダー層の処理: (あるモデルで使用)

- 過去の出力と入力間の関係性計算。

- 同じく、フィードフォワードネットワークと正規化。

- 出力層:

- 単語の確率分布の計算。

- 最も確率の高い単語の選択など。

- 後処理: トークンからテキストへの変換。

このプロセスは、特定の質問に対してモデルがどのように答えを形成するのかを理解するのに役立ちます。何か他の詳細や質問があればお知らせください。

You:

各ステップについて、専門用語を使わずより詳細に説明してください。

ChatGPT:

もちろん、専門用語を使わずに、各ステップについて詳しく説明します。

- 前処理:

- 質問文を小さな部分(単語や文字)に分解。

- 各部分に特別な数字を割り当てる。

- エンコーダー層の処理:

- 各部分が他の部分とどう関連するかを見つける。

- それぞれの部分を新しい形に変換し、それらを組み合わせて新しい意味を作る。

- 何度も繰り返して、全体の意味を作る。

- デコーダー層の処理 (一部のモデルで):

- 今までの答えの部分と新しい部分とを組み合わせる。

- それぞれの部分をさらに変換して意味を深める。

- 出力層:

- 最終的な意味から、可能な答えの中から最も良いものを選ぶ。

- これは、各単語が次に来る確率を計算することで行う。

- 後処理:

- 最後に選ばれた数字を、元の言語に戻す。

- これで、質問に対する答えが得られる。

このプロセスは、言語の理解と生成のためにコンピュータがどのように働くかを示しています。

何か他に知りたいことがあればお伝えください。

You:

これは、各単語が次に来る確率を計算することで行う。

この部分がよく分かりません。

確率を計算することで何を実現しているのですか?

ChatGPT:

この確率計算の部分について、具体的に説明します。

- 目的: 文章の生成において、自然で文法的に正しい次の単語を選ぶため。

- 方法: モデルは、ある単語の後に別の単語が続く確率を学習しています。

- 例: 「私は」の後に「リンゴを」と続く確率は高いが、「山を」と続く確率は低い。

- 結果: 最終的な文は、連続する単語の間の確率が高い組み合わせから構築されます。

つまり、この確率計算は、言葉が自然につながり、意味が通る文章を生成するための鍵となっています。

何か他に質問があればお知らせください。

You:

自然言語を生成する際に必要な処理という理解で合っていますか?

ChatGPT:

はい、その理解で正確です。

自然言語を生成する際に、単語がどのように自然に続くかを学ぶことで、人間が話すような自然で流暢な文章を生成することが可能になります。

このプロセスは、モデルが大量のテキストデータから学ぶことで実現されます。

何か他に質問や説明が必要であればお知らせください。

You:

前処理とエンコーダー層の処理に関して、LLMは入力となる言語をどのような形で認識しているのですか?

ChatGPT:

LLMが入力となる言語を認識する際の前処理とエンコーダー層の処理について説明します。

- 前処理:

- トークン化: 言語を小さな部分(トークン)に分割。単語や文字など。

- 数値化: トークンをモデルが理解できる数値に変換。

- ポジショナルエンコーディング: トークンの順序情報を追加。

- エンコーダー層の処理:

- 自己注意: 各トークンが他のトークンとどう関連するかを計算。

- 変換: 非線形変換を用いてトークンの新しい表現を生成。

- 結合: トークン間の関係を捉え、全体の意味を形成。

このプロセスを通じて、LLMは入力となる言語を複雑な数値形式で認識し、それを元に質問への回答などのタスクを実行します。

何か他の詳細が必要であれば、お知らせください。

You:

言語を変換したトークンには、 ・そのトークン自体の意味を表す数値 ・トークン間の関係を表す数値 のに種類の情報を持っているということでしょうか?

ChatGPT:

はい、その理解で正しいです。

言語のトークンが変換された後、以下の2つの主要な情報を持っています。

- そのトークン自体の意味を表す数値: 各トークンの意味や概念をキャプチャするための数値ベクトル。

- トークン間の関係を表す数値: 自己注意機構を通じて、各トークンが文中の他のトークンとどう関係するかの情報。

この2つの情報を組み合わせることで、LLMは文章全体の複雑な意味と構造を理解します。

何か他に質問があればお知らせください。

You:

ベクトルデータベースという言葉は、この辺りの知識と関係してきますか?

ChatGPT:

はい、ベクトルデータベースの概念は、大規模言語モデル(LLM)などの自然言語処理(NLP)と関連しています。

以下にその関連性について説明します。

- ベクトル表現: LLMでは、言語のトークン(単語など)を数値ベクトルで表現します。これはそのトークンの意味や関連性を捉えるものです。

- ベクトルデータベース: これらの数値ベクトルを効率的に管理、検索、比較するためのデータベースです。

- 検索と類似度: ベクトルデータベースは、特定のクエリに対する類似のベクトルを迅速に見つけることが可能で、類似性検索や推奨などに使用されます。

要するに、ベクトルデータベースは、言語や他の情報をベクトル形式で効率的に扱うための技術で、LLMと同じようにベクトルを利用する多くのアプリケーションと関連しています。

何か他に質問や詳細が必要であればお知らせください。

You:

ベクトルデータベースを構築する方法を教えてください。

ChatGPT:

ベクトルデータベースの構築にはいくつかの主要なステップがあります。

以下はその概要です。

- データの準備:

- ベクトル化するデータを選ぶ。

- 必要に応じて前処理。

- ベクトル化の方法選択:

- 特徴を抽出し、データをベクトル形式に変換。

- 例: 自然言語処理の場合、単語埋め込みなど。

- ベクトルデータベースエンジンの選択:

- 用途に応じたエンジンを選ぶ。

- 例: FAISS, Annoyなど。

- インデックスの構築:

- ベクトルデータベース内で効率的に検索できるようインデックス作成。

- パラメータチューニングが必要な場合も。

- クエリの処理:

- ユーザーからのクエリを受け付け、対応するベクトルを検索。

- 類似性計算などのロジックを実装。

- 保守と拡張:

- データベースの監視、バックアップ。

- 必要に応じて拡張や最適化。

これらのステップを通じてベクトルデータベースを構築し、効率的な検索や分析を実現します。

特定のツールや技術に関して具体的な質問があれば、お知らせください。

You:

GPT-4やBardといった様々なLLMが存在しますが、その仕組みや内部構造はそれぞれ異なりますか?それとも似通ったものですか?

ChatGPT:

GPT-4、Bardなどの大規模言語モデル(LLM)は、基本的なアーキテクチャや仕組みにおいては似通っていますが、詳細には違いがあります。

以下はその概要です。

- 共通点:

- アーキテクチャ: 両者ともトランスフォーマーのアーキテクチャを使用することが一般的です。

- 学習方法: 教師あり、教師なし学習など、基本的な学習方法は類似。

- 目的: 自然言語理解と生成のためのモデル。

- 違い:

- モデルサイズ: レイヤーやパラメータの数など、モデルのサイズや構造に違いがあることがあります。

- 学習データ: 使用されるデータセットや前処理の方法に違いがあることがあります。

- 最適化と調整: 各モデルは特定のタスクや性能要件に合わせて調整されることがあります。

要するに、基本的なアプローチやアーキテクチャは類似していますが、特定の用途や性能に応じて、実装の詳細や調整が異なることが一般的です。

何か他の詳細や具体的な質問があればお知らせください。

You:

GPT-3.5を使用した場合、英語で質問するときと日本語で説明するときでLLMが生成する回答の精度に差があるようです。

これは何が原因ですか?

ChatGPT:

GPT-3.5などのLLMが英語と日本語で回答の精度に差を示す場合、以下の原因が考えられます。

- 学習データの偏り:

- 英語のデータが豊富で、日本語のデータが少ない場合。

- 言語ごとの質の差も影響。

- 言語の複雑性:

- 文法や表現の複雑性が異なるため、モデルが一方の言語をもう一方より正確に理解する可能性。

- トークン化の違い:

- 英語と日本語ではトークン化の方法が異なることがある。

- これにより、モデルの理解に違いが生じる場合がある。

- 最適化と調整の差:

- モデルが特定の言語やタスクに対して最適化されている場合、他の言語での性能が下がることがある。

以上の点から、LLMが英語と日本語で異なる精度を示す場合があると言えます。

特定の問題に対しては、モデルの調整や前処理の改善などによって、性能の向上が図れることがあります。

何か他に質問や詳細が必要であればお知らせください。

You:

日本語は語順が一意に定まらないため、英語に比べて認識精度が低いという話を聞いたことがあります。

では、LLMが認識しやすい言語というのは、どのような条件を備えた言語なのでしょうか?

ChatGPT:

LLMが認識しやすい言語は、一般的に以下のような条件を備えた言語になります。

- 一貫した文法規則:

- 規則性が高く、例外が少ない言語。

- 豊富な学習データ:

- 学習に使用できる大量の高品質データが存在する言語。

- 明確なトークン化のルール:

- 単語や文節の区切りが明確で、トークン化が容易な言語。

- 語順の一意性:

- 語順が一意に定まると、構文解析が容易で、誤解釈のリスクが低くなる。

- 豊富な文脈情報:

- 言語が文脈に依存しない明確な意味を持つ場合、理解が容易。

- 共通の文字セットや表記規則:

- 文字セットや表記が一定であると、前処理や解析が簡単になる。

これらの条件は一般的な指針であり、特定のモデルやタスク、学習データなどによって、実際の「認識しやすさ」は異なる場合があります。

特に、学習データの品質や量は、多くの言語モデルで重要な要素となります。

何か他の質問や詳細が必要であればお知らせください。

You:

トークン化が容易、という部分についてより詳しく教えてください。

ChatGPT:

トークン化が容易な言語というのは、その言語の文字や単語、句読点などの区切りが明確で、機械学習モデルが解析しやすい状態にあることを指します。

以下は、その詳細な要点です。

- 単語の区切りが明確:

- スペースや特定の文字で単語が区切られている言語(例:英語)。

- 単語間の境界を判定しやすい。

- 表記が一定:

- 単語のスペリングや文法が一定で規則的な言語。

- 表記揺れが少ないと、トークン化のルールを設定しやすい。

- 特殊な文字や記号の少なさ:

- 記号や特殊文字の使用が一貫していて、解釈が容易な言語。

- 文脈に依存しないトークン化:

- 文脈によって単語の区切りが変わらない、または変わりにくい言語。

- トークン化のツールやリソースの豊富さ:

- 既存のトークン化ライブラリや辞書などのリソースが豊富な言語。

例えば、英語の場合、スペースによって単語が区切られるためトークン化が容易です。

一方、日本語のように単語の境界が明確でない場合、トークン化は複雑になり、専門のライブラリや手法が必要となることが多いです。

トークン化が容易な言語では、前処理が簡単でエラーが少なく、結果としてモデルの学習や解析が効率的に進行することが一般的です。

何か他に質問や詳細が必要であればお知らせください。

You:

現在存在する言語のうち、これらの条件を考えたときに最もLLMにとって認識しやすい言語はなんだと思いますか?

学習データの多さについては考えなくて良いです。

ChatGPT:

学習データの多さを除いて、LLMにとって認識しやすい言語を考えると、以下のような特徴を持つ言語が該当する可能性があります。

- 単語の区切りが明確(例:スペースで区切られる)

- 文法規則が一貫している

- 言語の複雑性が低い

- トークン化のルールが明確

これらの条件を満たす言語には、一般的にロマンス語やゲルマン語などが含まれることが多いです。具体的には、英語やスペイン語、ドイツ語などが挙げられることがあるでしょう。

ただし、最も認識しやすい言語を一意に決定するのは難しいです。

なぜなら、どの言語が「認識しやすい」かは、特定のタスクやモデル、前処理手法などに依存するからです。

同じ言語でも、異なるタスクや条件下での認識のしやすさは変わる可能性があるため、一般化するのは慎重であるべきでしょう。

何か他に質問や詳細が必要であればお知らせください。

You:

英語という言語を改良してよりLLMが認識しやすい言語にするには、どのような改良が考えられるでしょうか?

ChatGPT:

英語をLLMがさらに認識しやすく改良するために、以下のような方向性が考えられるでしょう。

- 規則性の強化:

- 不規則な動詞の形やスペル揺れを減らす。

- 一貫した文法規則の導入。

- 単語の境界明示化:

- 合成語の区切りなど、単語の境界を明示化する方法を導入。

- 文脈依存の減少:

- 同じ単語でも文脈によって意味が変わる場合が多い英語において、これを減らす。

- 意味の一意化:

- 多義語の意味を一意にするなど、曖昧性を減らす。

- 標準化された表記:

- 異なる表記やスラング、方言を標準化。

- 専門用語と一般用語の明確化:

- 専門的なコンテキストでの用語の使用を明確にする。

- 簡略化の導入:

- 言語の複雑性を減らし、簡潔な表現を推奨。

- 注音記号の導入:

- 発音と書き文字のギャップを減らすため、発音を明示する記号などを導入。

これらの改良は、理論上はLLMの認識しやすさを向上させる可能性がありますが、現実的な観点からは、言語の自然さや人間にとっての使いやすさ、文化的側面なども考慮する必要があります。

言語はコミュニケーションの道具であり、その機能や美学を犠牲にしてまで機械に適応させる必要はないかもしれません。

何か他に質問や詳細が必要であればお知らせください。

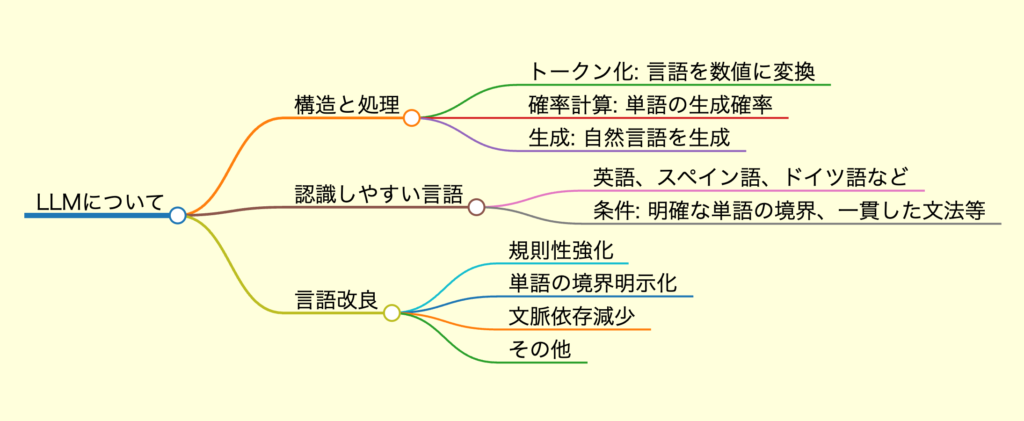

You:

今までの会話を整理したいです。

日本語でマインドマップの形で下記のステップでまとめてください。

1.まず「マインドマップ:」という文字列を先頭に入れてください。

2.そして改行を入れてください。

3.マインドマップの内容を作ってください。

必ずmarkdownの記述方式で出力してください。

ChatGPT:

もちろんです、以下のように整理しました。

何か追加や変更が必要な点がありましたらお知らせください。

You:

今までの会話をブログに作りたい。

マインドマップ作成の内容を除いて、 タイトルと集約文、そしてSEO対応のため、キーワードを「,」区切りでまとめてください。

出力文のフォーマットは「タイトル:」「集約文:」「キーワード:」の形でお願いいたします。

「タイトル:」「集約文:」「キーワード:」は改行2回で区切りしてください。

そして「タイトル」「集約文」「キーワード」以外の説明がいりません。

そして日本語で出力してください。

ChatGPT:

もちろんです、以下の形式で出力します。

以上の内容で問題ないでしょうか?

何か追加や変更が必要な点がありましたらお知らせください。